Learn Llm

Learn Llm

February 17, 2025

pre-training

https://huggingface.co/spaces/HuggingFaceFW/blogpost-fineweb-v1

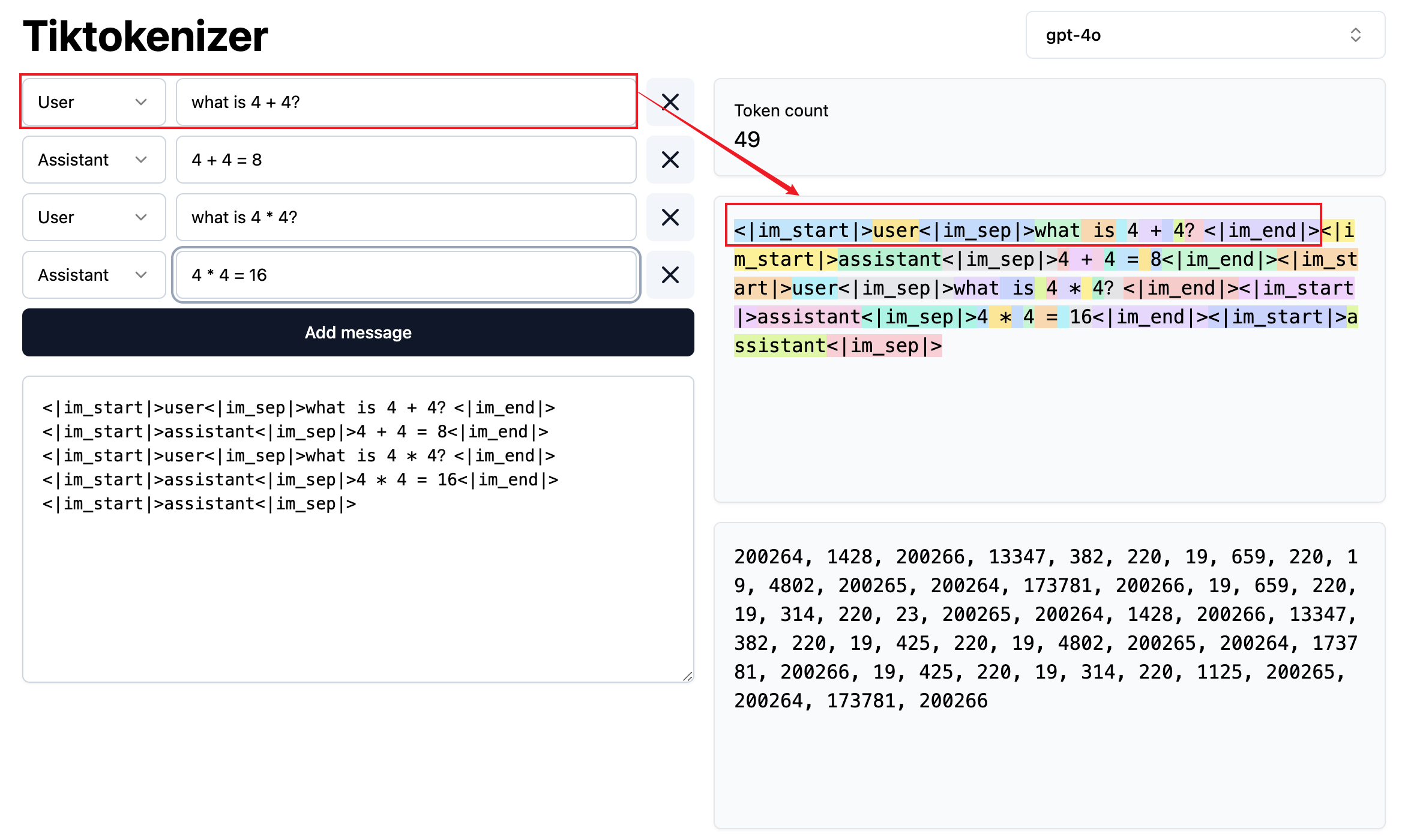

100000 symbols(tokens) raw text —>tokenization —> token

tokenization

https://tiktokenizer.vercel.app/?model=cl100k_base

statistic token simulator

- 这就是所谓的 prediction

- 参数 各个 token 的权重

- 模型有大量的知识,存储在上亿的参数之中。这些参数可以视为对超大规模的知识进行的一种有损压缩。超大规模知识的模糊记忆。

- 按照统计规律给出所谓的答案

- 模型需要中间结果

- 概率、统计

- in-context learning

post-training

对话集结构 —> 一维 token 序列

instruct-gpt

强化学习 reinforcement learning 监督学习 supervised earning supervised-fine-tuning

References

Last updated on